"Es ist gut möglich, dass wir einen Tsunami von Fehlinformationen erleben werden." In einem Interview mit der New York Times findet der KI-Forscher Oren Etzioni dramatische Worte für seine Bedenken im heurigen Superwahljahr. Und diese Sorgen sind berechtigt.

Eine Rekordzahl an Wählerinnen und Wählern wird heuer zu den Urnen gebeten, um über die Zukunft von knapp vier Milliarden Menschen zu entscheiden. Die jüngere Vergangenheit lieferte bereits einen Vorgeschmack auf die neue Realität: Fake-Anrufe von Joe Biden sollen Demokraten von den Vorwahlen fernhalten, Taylor Swift findet sich in millionenfach geteilten Deepfake-Nacktbildern wieder, ein Finanzmanager einer Bank in Hongkong überweist 25 Millionen Dollar an Betrüger, die sich mittels Deepfake-Technologie in einem Videocall als seine Vorgesetzten ausgegeben haben. Ein neues Tool soll nun die Erkennung politischer Deepfakes wesentlich erleichtern, um den Schaden im weiteren Verlauf des Jahres im Idealfall minimieren zu können.

Non-Profit-Organisation bekämpft politische Deepfakes

Oren Etzioni ist emeritierter Professor an der University of Washington und zählt zu den Pionieren der Metasuche, der Onlinevergleichsportale und des maschinellen Lesens. Im Jahr 2013 war er Gründungsgeschäftsführer des Allen Institute for AI (AI2), als dessen CEO er bis Ende 2022 tätig war. AI2 gilt heute als eines der angesehensten KI-Forschungsinstitute weltweit.

Doch seine Begeisterung für die KI-Technologie ist mittlerweile getrübt. Schon 2019 warnte Etzioni vor der Verbreitung von Desinformation mithilfe von KI, im Jänner gründete er truemedia.org – eine Non-Profit-Organisation, die sich dem Kampf gegen politisch motivierte Deepfakes verschrieben hat. Im April veröffentlichte die Organisation die Betaversion ihres Deepfake-Detektors. Dieser soll verdächtige Bild- und Tonaufnahmen binnen kürzester Zeit erkennen können.

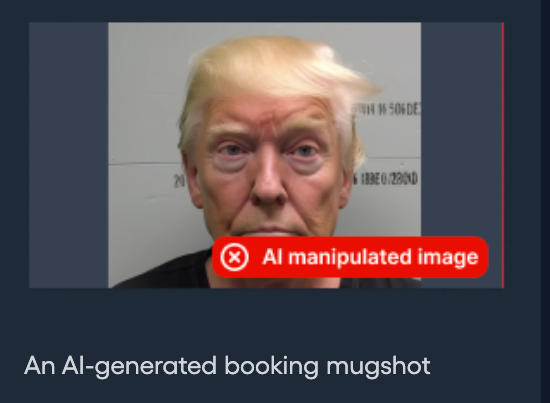

In einem Interview mit der New York Times zeigt Etzioni, wie einfach sich brisante Bilder erstellen lassen. Mithilfe eines Dienstes von CivAI, einer Schwesterorganisation, die auf die Gefahren frei verfügbarer KI-Tools hinweist, fertigt er kurzerhand ein Bild von sich selbst im Gefängnis an, wenig später eines von sich im Krankenbett. Derartige Bilder könnten eine Wahl entscheidend beeinflussen, wenn sie beispielsweise Biden oder Trump zeigen würden, meint Etzioni.

Wie funktioniert der Deepfake-Detektor?

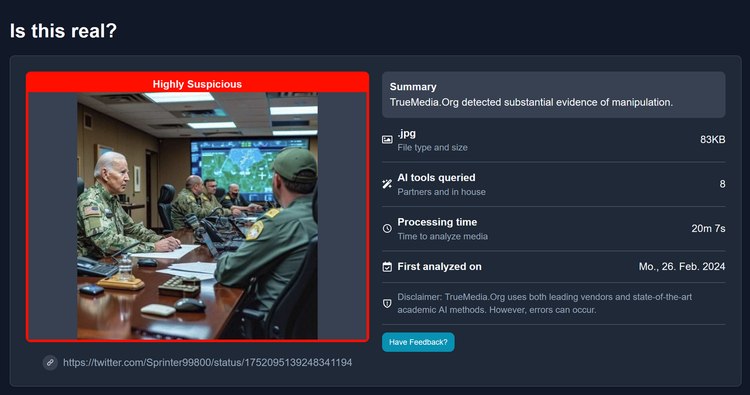

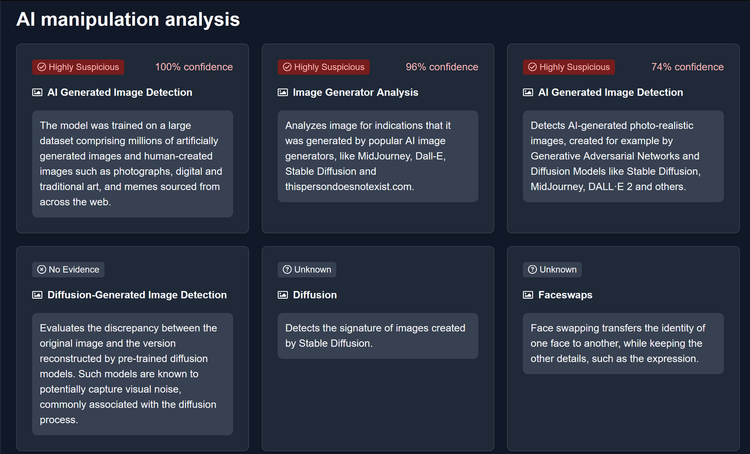

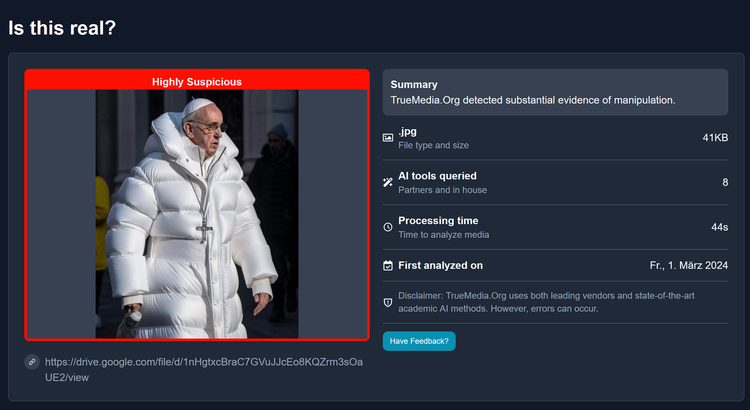

In einem zweiminütigen Video wird die Funktionsweise des Tools erklärt: Stolpert man auf X (vormals Twitter) über ein politisch brisantes Bild wie jenes von Joe Biden, der sich zu Beginn des Israel-Hamas-Konflikts vermeintlich mit seinen Topmilitärs traf, ist Vorsicht geboten. Zur Überprüfung wird die URL der Bildquelle in den Detektor kopiert. Die Analyse dauert, je nach Material, zwischen einigen Sekunden und mehreren Minuten. Den Balenciaga-Papst entlarvt das Tool beispielsweise innerhalb von 44 Sekunden, für Biden am Tisch mit den Topmilitärs benötigt das Programm 20 Minuten. Das Fazit in beiden Fällen: "highly suspicious", die höchste Stufe auf der Skala.

Technologien anderer Detektoren berücksichtigt

Die Analyse schlüsselt die unterschiedlichen Manipulationsmöglichkeiten auf, Konfidenzintervalle zeigen an, mit welcher Wahrscheinlichkeit eine bestimmte Methode bei dem analysierten Bild- oder Tonmaterial zum Einsatz gekommen ist. Die Technologie des Truemedia-Detektors verwendet hierfür hauseigene Modelle, man arbeitet aber auch mit namhaften Partnern wie Hive, Clarity, Reality Defender oder Sensity zusammen.

"Wir haben den Vorteil, dass wir sowohl deren Tools als auch unsere eigenen, auf akademischer Forschung basierenden Erkennungsmethoden nutzen können", erklärt Truemedia auf Anfrage des STANDARD. Im Gegensatz zu anderen Anbietern habe man sich aber auf politische Deepfakes spezialisiert.

Das neue Tool soll zu einer Verbesserung der derzeitigen Situation beitragen, die eher einem Flickwerk an Maßnahmen gegen irreführende, KI-generierte Inhalte gleicht. Getestet wird unter anderem auf Gesichtsmanipulationen, den Austausch von Gesichtern und "visual noise", also visuelle Artefakte und Verunreinigungen digitaler Bilder.

Manipulierte Fotos, KI-generierte Tonspuren

Auch das manipulierte Familienfoto von Prinzessin Kate und ihren Kindern, das Gerüchte um ihre Gesundheit hätte entschärfen sollen, ist unter den Demo-Bildern zu finden. Obwohl es sich hier lediglich um ein auf herkömmliche Weise bearbeitetes Foto handelt, findet der Detektor zahlreiche Ungereimtheiten mit hohen Konfidenzintervallen. Der Grund: "Einige der Photoshop-Funktionen nutzen KI und gehen weit über geringfügige Bearbeitungen hinaus", erklärt Truemedia auf Anfrage. Die Analyse deute auf eine erhebliche Inanspruchnahme KI-basierter Bearbeitungsmethoden hin.

Dass sowohl KI-generierte Tonspuren als auch Deepfake-Videos zuverlässig erkannt werden, wird mithilfe einer gefälschten Videobotschaft von Alvin Bragg, Bezirksstaatsanwalt von Manhattan und Ankläger Donald Trumps, demonstriert.

Betaversion vorerst nur bei Anmeldung

Wer den Detektor testen möchte, kann sich auf der Webseite mittels E-Mail-Adresse anmelden. Das Tool ist jedoch vorerst nur jenen Gruppen vorbehalten, von denen eine integre Nutzung zu erwarten ist: Medienleuten, Regierungsmitarbeitern oder professionellen Faktencheckern.

Eine Anmeldung mit einer privaten Gmail- oder Outlook-Adresse ist derzeit nicht möglich. Auf Anfrage teilte Truemedia dem STANDARD mit, dass grundsätzlich geplant sei, den Deepfake-Detektor auch einem breiteren Publikum zur Verfügung zu stellen. Vorerst müsse man aber noch die Kosten für das Gratistool niedrig halten. Außerdem wolle man verhindern, dass die Technologie von der Gegenseite zur Verbesserung der Deepfake-Generatoren genutzt wird.

Vollständige Sicherheit niemals möglich

Laut Etzioni werde aber auch der beste Detektor niemals perfekt sein. Das Problem lasse sich nur durch weitreichende Zusammenarbeit zwischen staatlichen Regulierungsbehörden, den entwickelnden Unternehmen und den Betreibern von Webbrowsern und sozialen Netzwerken lösen.

"Wir versuchen den Menschen die beste technische Auswertung dessen zu liefern, was sie vor sich haben. Sie müssen aber immer noch selbst entscheiden, ob etwas real ist oder nicht." (Lisa Haberkorn, 4.5.2024)